Een dashboard voor derden om algoritmen onder de loep te nemen

Steden gebruiken steeds meer algoritmen om het leven te besturen en de besluitvorming te ondersteunen. Tegelijkertijd kan algoritmische besluitvorming het fundamentele mensenrecht op autonomie schaden. Ons team ontwikkelde een dashboard waarmee mensen algoritmes onder de loep kunnen nemen.

De Nederlandse overheid wil ervoor zorgen dat de implementatie en het gebruik van algoritmen binnen wettelijke kaders gebeurt en wil het toezicht op algoritmen en gegevens verbeteren.

Bij Responsible Sensing Lab vinden we dat algoritmen die door de overheid worden gebruikt eenvoudig te overzien moeten zijn. Daarnaast blijft het een kernprincipe van onze democratische samenleving om overheidsprocedures en -systemen te kunnen controleren.

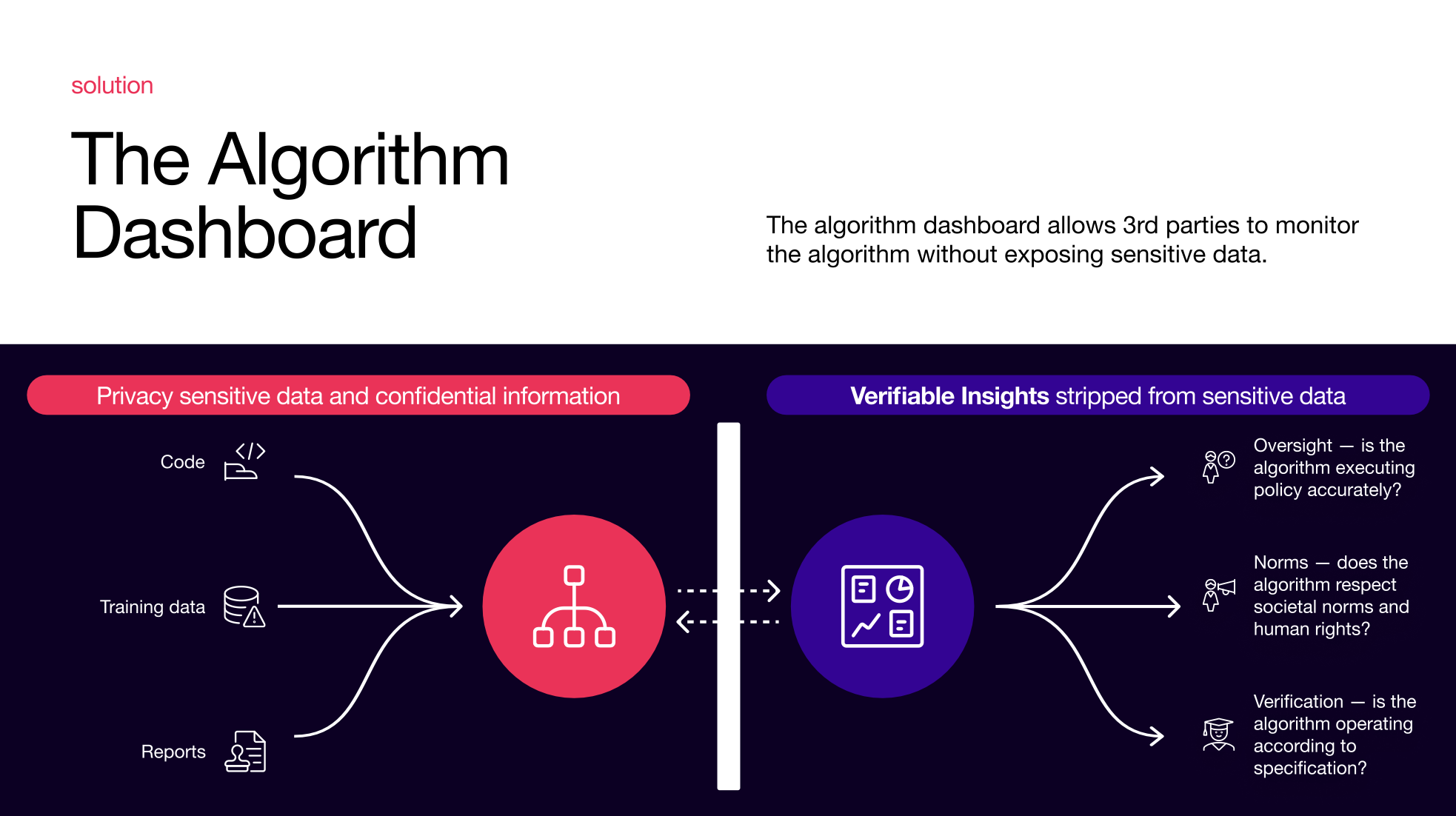

De uitdaging: hoe kunnen we - als samenleving - algoritmische uitkomsten kritisch bekijken om de effectiviteit, discriminatie of willekeur te controleren zonder privacygevoelige of vertrouwelijke informatie bloot te leggen?

Een voorbeeld: handhaving op basis van algoritmen

Klassieke handhaving

Een administratief medewerker beslist hoe de wet wordt uitgevoerd om beleidsregels af te dwingen. De ervaren effecten van deze handhaving kunnen worden beïnvloed door politieke acties die nieuwe wetten en de manier waarop ze moeten worden gehandhaafd, informeren.

Algoritmisch advies

De administratief medewerker implementeert de regels in een algoritme dat helpt bij de handhaving (op wie moet je je richten). De ervaren effecten van deze handhaving zijn moeilijker te beïnvloeden, omdat de handhaving door het algoritme een black box is.

In dit geval: hoe kunnen bezorgde burgers begrijpen hoe het algoritme de regels implementeert? Waar kunnen ze terecht met hun zorgen?

Kenmerken van ‘betwistbare AI’

In het onderzoek van Kars Alfrink, onlangs gepubliceerd in Minds and Machines, wordt een selectie van kenmerken beschreven die nodig zijn om AI betwistbaar te maken. Bijvoorbeeld ingebouwde waarborgen met formele beperkingen, traceerbare besluitvormingsketens, de mogelijkheid om interventieverzoeken in te dienen en tools voor toetsing. Tijdens deze verkenning richtte het team zich op het laatste.

Tools voor tegenspraak zijn vormen van informatie over AI-systemen die externe partijen, zoals toezichthouders, NGO’s, journalisten en politici, kunnen gebruiken om ervoor te zorgen dat systemen binnen aanvaardbare normen opereren en om wijzigingen aan te vragen indien nodig.”

— Kars Alfrink, PhD kandidaat, TU Delft

Een dashboard voor mensen om algoritmen onder de loep te nemen

Een dashboard kan derden helpen om de werking van een algoritme onder de loep te nemen. Bezorgde burgers kunnen zich tot hen wenden om te begrijpen hoe de regels worden geïmplementeerd en genoeg geïnformeerd zijn om te proberen de implementatie te beïnvloeden.

Om te verkennen hoe dit zou kunnen, hebben we een ontwerptraject opgezet met onderzoeker Kars Alfrink (TU Delft) en The Incredible Machine.

Het resultaat van deze verkenning: een dashboard waarmee mensen wier taak het is om toezicht te houden op de overheid (bijv. raadsleden, belangengroepen van burgers) een specifiek algoritme kritisch kunnen bekijken.

Uitdagingen voor kritisch onderzoek

Hoe kun je een algoritme controleren als je de gegevens die worden verwerkt niet mag zien?

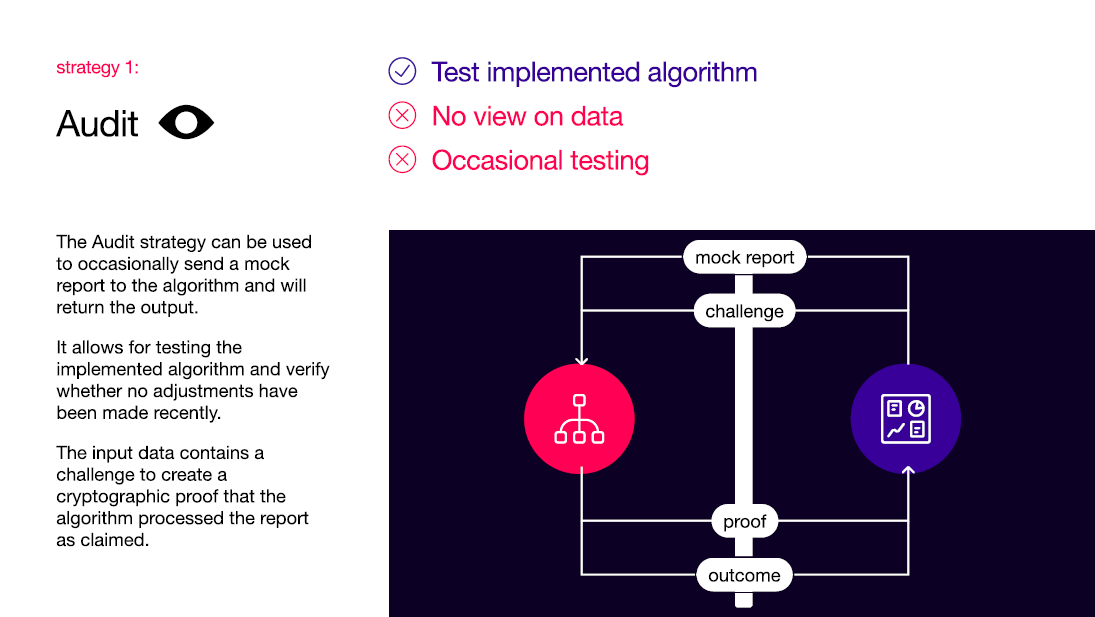

- Auditstrategie

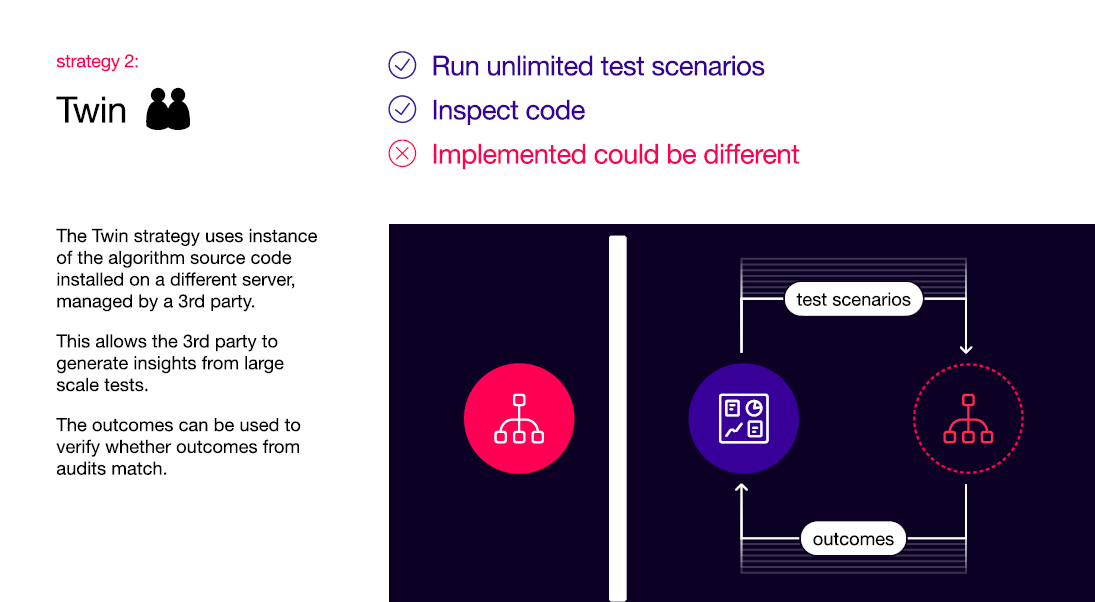

- Tweelingstrategie

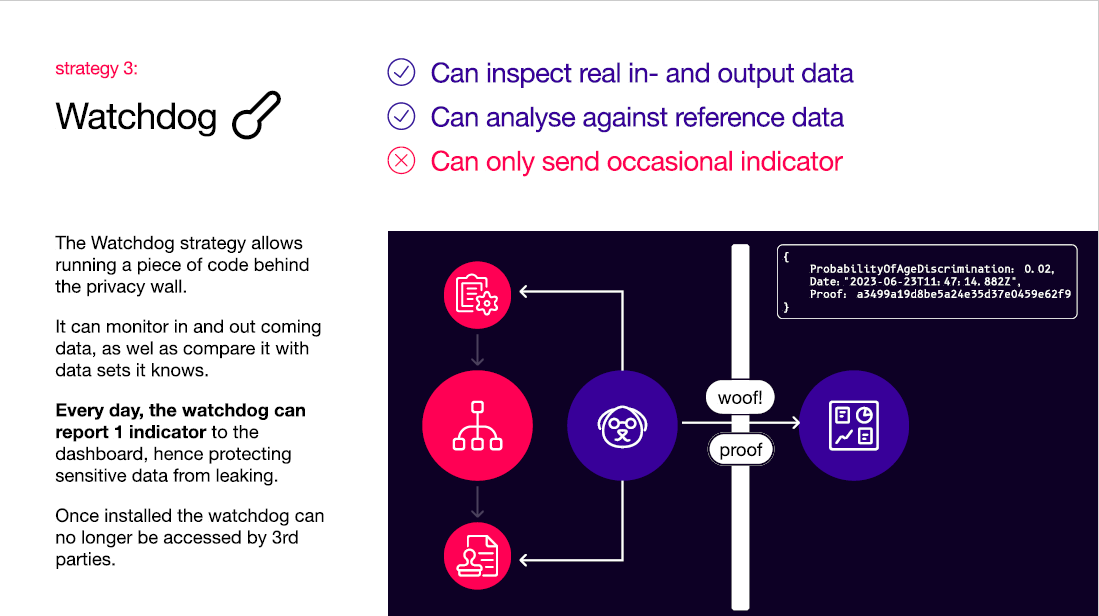

- Waakhondstrategie

1. Audit

Responsible Sensing Lab Audit - De auditstrategie kan worden gebruikt om af en toe een nep rapport naar het algoritme te sturen en geeft de uitvoer terug. Hiermee kan het geïmplementeerde algoritme worden getest en kan worden geverifieerd of er recentelijk geen aanpassingen zijn gedaan. De invoergegevens bevatten een uitdaging om een cryptografisch bewijs te maken dat het algoritme het rapport heeft verwerkt zoals beweerd.

2. Tweeling

Responsible Sensing Lab Twin - De tweelingstrategie maakt gebruik van instanties van de broncode van het algoritme die op een andere server zijn geïnstalleerd en door een derde partij worden beheerd. Hierdoor kan de derde partij inzichten genereren uit grootschalige tests. De uitkomsten kunnen worden gebruikt om te controleren of uitkomsten van audits overeenkomen

3. Waakhond

Responsible Sensing Lab Watchdog - Met de waakhondstrategie kan een stuk code achter de privacy muur worden uitgevoerd. Het kan inkomende en uitgaande data monitoren en vergelijken met datasets die het kent. Elke dag kan de watchdog 1 indicator rapporteren aan het dashboard, waardoor gevoelige gegevens worden beschermd tegen lekken. Eenmaal geïnstalleerd is de watchdog niet meer toegankelijk voor derden.

We hebben dit dashboard gepresenteerd aan raadsleden en academici tijdens een workshop op het AMS Institute. Het ontwerp concept toont hoe het mogelijk is om algoritmes te monitoren terwijl gevoelige gegevens worden beschermd. Dit vereist wel een gedegen betrokkenheid en samenwerking tussen overheidspartijen en algoritmeprogrammeurs. Ook is een uitgebreide inzet voor privacy nodig en zijn er standaarden nodig om modellen voor controle te realiseren.”

— Fabian Geiser, Project Manager, Responsible Sensing Lab